python爬虫模拟浏览器访问-User-Agent过程解析

这篇文章主要介绍了python爬虫模拟浏览器访问-User-Agent过程解析,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友可以参考下

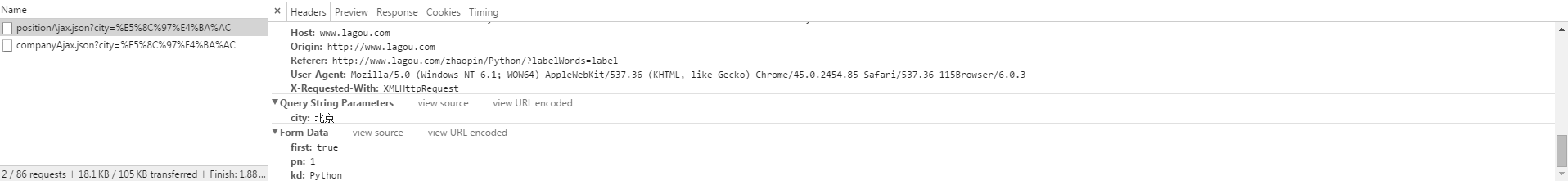

模拟浏览器访问-User-Agent:

import urllib2

#User-Agent 模拟浏览器访问

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.88 Safari/537.36"}

#通过urllib2.Request()方法构造一个请求对象

request = urllib2.Request("http://www.baidu.com/",headers = headers)

#向指定的URL地址发送请求,并返回服务器响应的类文件对象

#response是服务器响应的类文件,除了支持文件操作的方法外,还支持以下常用的方法:

response = urllib2.urlopen(request)

#服务器返回的类文件对象支持python文件对象的操作方法

#read()方法就是读取文件里的全部内容,返回字符串

html = response.read()

#返回HTTP的响应码,成功返回200,4服务器页面出错;5.服务器问题

print response.getcode()

#返回实际数据的实际URL,防止重定向问题

print response.geturl()

#返回服务器响应的HTTP报头

print response.info()

#打印响应内容

print(html)

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持【听图阁-专注于Python设计】。