python基于BeautifulSoup实现抓取网页指定内容的方法

本文实例讲述了python基于BeautifulSoup实现抓取网页指定内容的方法。分享给大家供大家参考。具体实现方法如下:

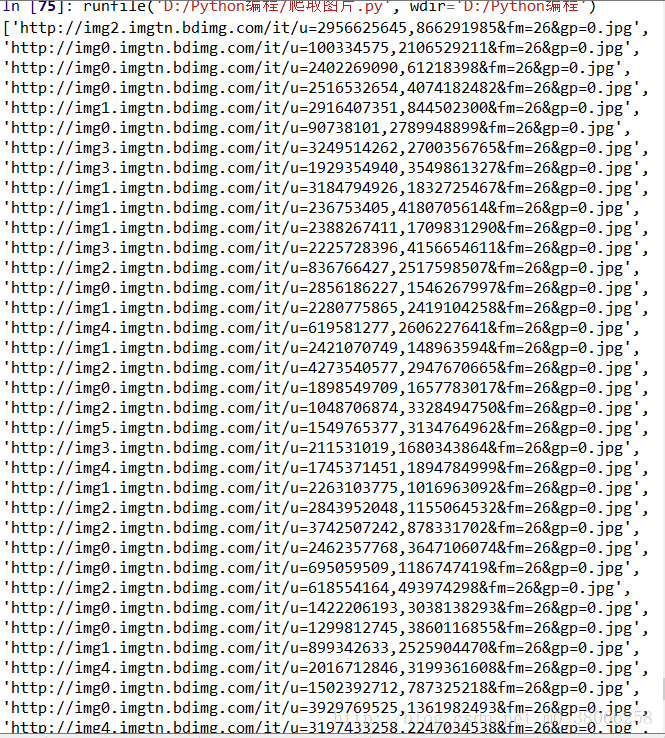

# _*_ coding:utf-8 _*_

#xiaohei.python.seo.call.me:)

#win+python2.7.x

import urllib2

from bs4 import BeautifulSoup

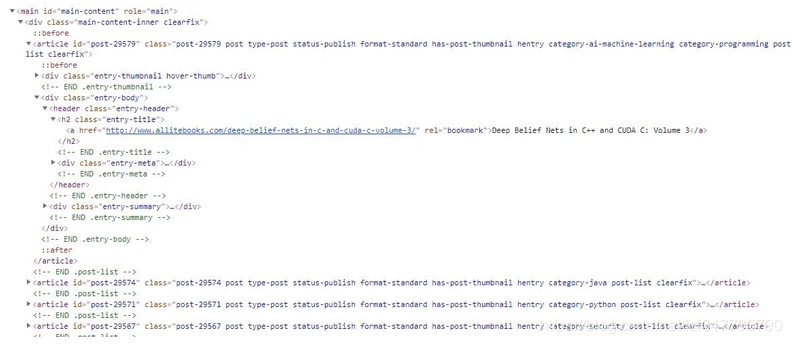

def jd(url):

page = urllib2.urlopen(url)

html_doc = page.read()

soup = BeautifulSoup(html_doc.decode('gb2312','ignore'))

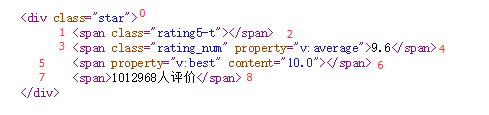

for i in soup.find_all('div', id="sortlist"):

one = i.find_all('a')

two = i.find_all('li')

print ("%s %s" % (one,two))

jd("http://channel.jd.com/computer.html")

希望本文所述对大家的Python程序设计有所帮助。